圍棋程式「Master」在弈城網對決世界頂級棋手,60 戰 60 勝,「人工智能超越人類」一類標題繼去年 3 月再度洗版。Master 後來公佈身分,就是 AlphaGo 的升級版。除來自英國的 AlphaGo 外,人工智能圍棋程式還有日本的「DeepZenGo」、南韓的「石子旋風」,隨著稍後 A.I. 進駐人類正式棋賽,今年被視為「人機決戰之年」。棋界乃至人界對此不表樂觀,但事實是,人工智能並無攻克圍棋,甚至未有超越人類。

首先,是次 Master 網上對弈下的是 30 秒 1 手的「超快棋」(對聶衛平則是 1 分鐘 1 手),快棋極度依賴棋感,誤著相當普遍,就算是頂尖職業棋手,思考時間不足,難以算準變化,本來就無法代表棋手的實力,連李世石對 AlphaGo 五番棋各 4 小時賽制也不算長--相比 1939 年吳清源對木谷實的經典十番棋,每局雙方各有 13 小時,3 日終局(期間兩人更打掛去浸溫泉)。而且,人類無法比擬電腦的運算能力與速度,人對人的規則未必適用於人機博弈。

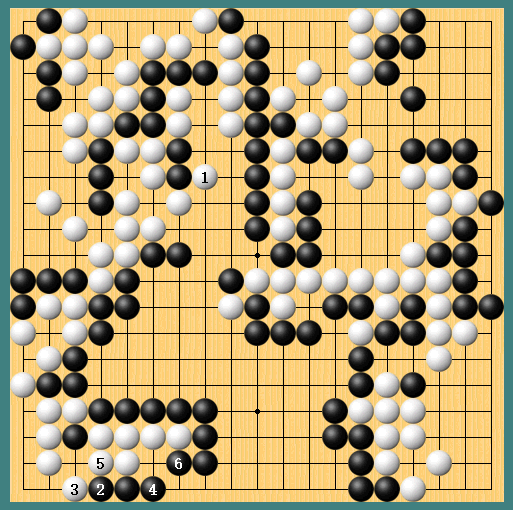

運算能力與速度不及電腦,不代表棋手必敗無疑,因為人工智能也會出現漏算。譬如去年人機博弈第四局,李世石在 78 手使出「手筋」,AlphaGo 漏算此著,誤判攻防直接導致中盤認輸。後來黃士傑博士解釋,AlphaGo 的失誤源於兩大原因:一、正解的變化組太深,策略網絡(policy network)無法有效引導 AlphaGo 細算到有利的變化;二、第 78 手機率極微,以致於 AlphaGo 進入了在自我對弈時甚少面對的局面,導致估值網絡(value network)誤判。雖然黃士傑表示隨 AlphaGo 持續進步,問題已經「解決」,由新版 AlphaGo 從 79 著接手,能夠下出對黑方有利的變化,但圍棋的變化組接近無限,所謂「手筋」,其實就是「意想不及、貌似誤著卻是正著」的一手,在對弈中不算常見也不罕見,應付到某一局的妙著,下一局又會有新神手,正如不可能從根本上解決「意外」,只能減少出現的頻率;而 AlphaGo 採用結合運算及估值的系統(例如計算目前「最佳」10 至 20 步棋,從中評估利害,再按「勝率」下子),這種模仿人腦思維的模式本身就存在人類盲點(DeepMind 創辦人 Demis Hassabis 曾指希望藉人工智能破解人腦思考謎團),更不用提 AlphaGo 所輸入的數據本身就是人類棋譜。

AlphaGo 實力毋庸置疑,但按「勝率」決定落子的機制亦不無問題,尤其不利佈局,因為子數不足,無從研判局勢,必須依賴對弈經驗,正如聶衛平的覆盤結論所示,Master 失誤少,但開局甚為不利(棋譜見此)。另外,「勝率先決」亦會導致電腦「遇弱愈弱」,例如在 Master 對陳耀燁一局中,前者在收官(終局)時犯下不少低級失誤,令人咋舌,概因電腦研判勝率甚高,開始放軟手腳。收官階段或者影響有限,中盤放水就關連甚大,李世石對 AlphaGo 的棋局就不乏後者在中盤領先時下出緩著的例子。人工智能只求勝出,不求擴大優勢,表示棋手只要把握機會,隨時能夠扭轉局面。

話雖如此,棋手要向「大師」學習的相當多,如聶衛平指出,Master「改變了傳統的厚薄理念(相對於薄,多子圍空叫厚),顛覆了多年的定式(定石:佈局指定走法)」,參考電腦的下法,亦能補足既定棋路的不足,將每一子的效力發揮得更盡。棋盤天地無限,人工智能與棋手同在探索路上,有時在前有時在後,總之都是「圍棋之神」為人指路而來。