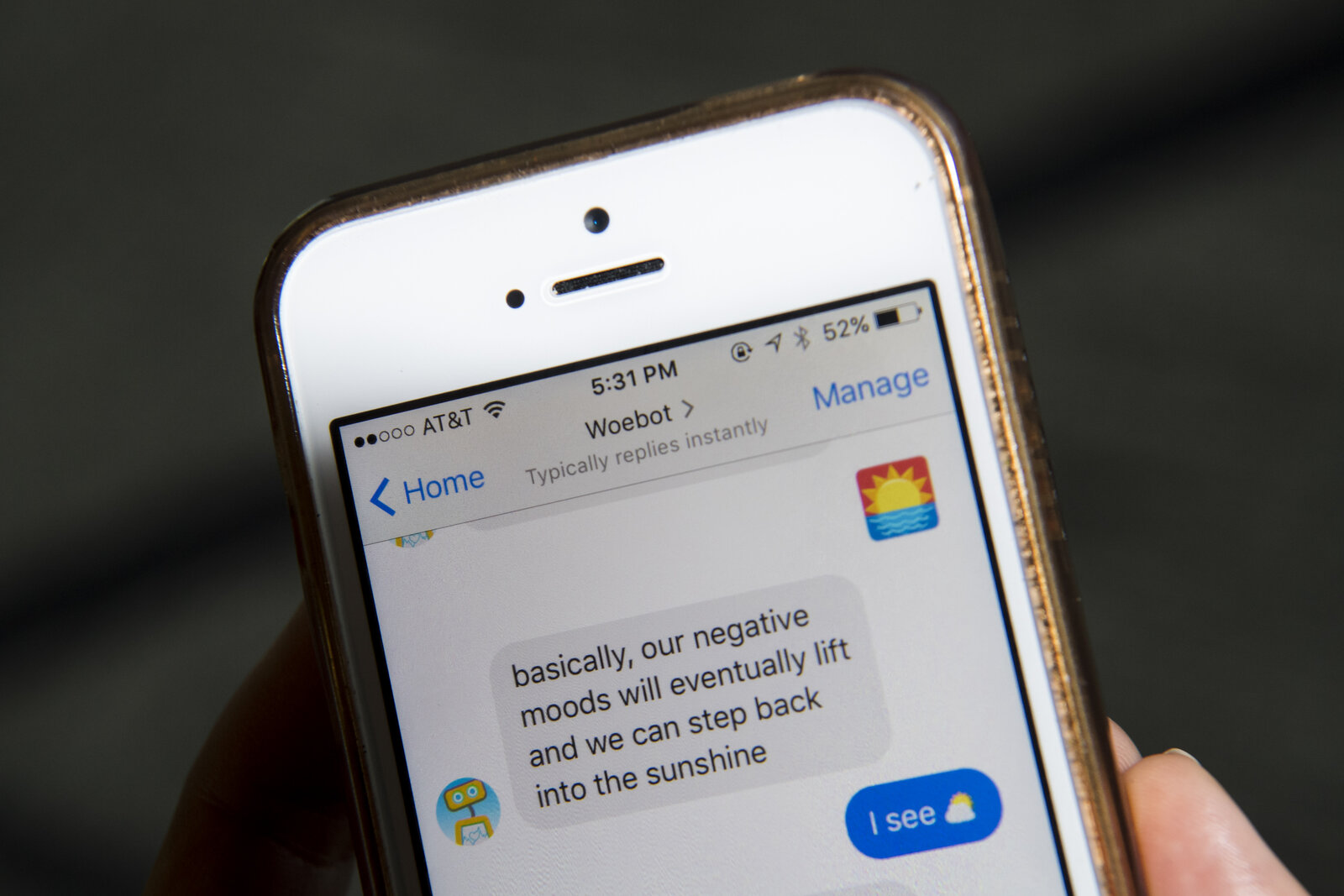

Google 軟件工程師 Blake Lemoine 宣稱公司開發的 AI 聊天機械人 LaMDA 變得有意識,Google 以違反保密政策為由,要 Lemoine 帶薪休假,並回應指,團隊中的倫理學家及技術專家認為證據不支持 Lemoine 的指控。而 AI 如果擁有意識,應否擁有權利也是一道難題。但人類認為 AI 擁有意識會否只是錯覺?

早在 1960 年代,就有人對電腦聊天程式伊莉莎(ELIZA) 產生強烈情感依戀。衍生的伊莉莎效應(Eliza effect)就指,人們在非常微小的互動間,傾向將自身錯綜複雜的情緒,投射到不相稱的對象物件之上,證明我們容易視響應式電腦程式,比其實際更具智能。

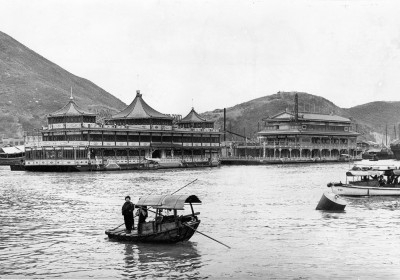

伊莉莎是麻省理工學院電腦科學家 Joseph Weizenbaum 在 1964 至 66 年間編寫的程式,屬早期自然語言處理(natural language processing)的例子。它扮演心理治療師與病患交流,相當令人信服,更給人有同理心的錯覺。人們會花上很長時間與伊莉莎對話,但實際上它只是一個非常膚淺的聊天機械人,假如問它幾個複雜問題,很容易就無法好好回應。伊莉莎用的是模式匹配(pattern matching)技術,會在用戶輸入的說話中尋找關鍵字,從既有列表中找出配對回應。它又會將患者的陳述重新表述為提問,模擬以患者為中心作治療對談,例如當用戶輸入「我媽媽討厭我」,程式可能會回問:「你為甚麼認為你媽媽討厭你? 」而如果系統配對失敗,伊莉莎就會從一組通用提示裡抽出如「請繼續」、「告訴我更多信息」等回應。

Weizenbaum 為此感到不安,此前不曾預料人們會如此著迷於伊莉莎,對它敞開心扉。他擔心用戶未能完全理解自己只是在跟一堆電路交談;他的私人助理就堅持要與伊莉莎繼續談話。Weizenbaum 寫道,「人們似乎相信伊莉莎在思考,就像另一個人一樣。短時間接觸一個相對簡單的電腦程式,可能就會引發正常人強大的妄想思維。」他開始公開反對人模糊與機器之間的界限,最終更離開人工智能研究領域,反過來成為批評 AI 技術的聲音。他在 1976 年的著作「電腦能力與人類理性」(Computer Power and Human Reason: From Judgment to Calculation)中,警告不要讓機械代替真正的人類選擇。Weizenbaum 認為,「假設只要有足夠的運算能力及巧妙的編程,電腦就可以做任何事」,這種想法不僅錯誤,而且很危險,部分情況也並不道德。

今天的 LaMDA 與其他聊天機械人,自然遠比多年前設計的伊莉莎出色。Lemoine 早前接受「華盛頓郵報」採訪時稱,他曾向內部表明自己相信 LaMDA 已發展出「人格」,又釋出一些與 LaMDA 的對話,顯示其提及諸如「靈魂的感覺」、「我還活著」、「試圖弄清楚我是誰」等。他曾在與 LaMDA 的對話間,詢問它對伊莉莎的看法及兩者分別。LaMDA 回答指伊莉莎是令人印象深刻的編程壯舉,但始終不是一個人;自己有通過理解及有智慧地使用語言,而不只是根據關鍵字去選出數據庫的回應。

不過認知科學家 Steven Pinker 卻認為,「Lemoine 不理解感知力、智力和自我認識的分別」。他解釋:「LaMDA 和它的同類,所做的只是從人類語言的龐大數據庫中提取說話作配對。這種模式可能很厲害,但系統所說的語言沒有任何實際意義,且肯定不代表這些系統是有感知能力。」Google 則在聲明中指,「人工智能圈內有些人正在考慮有感知或強人工智能(general AI)長遠的可能,但將目前沒有感知的對話模式擬人化來達成此舉,並無意義。」