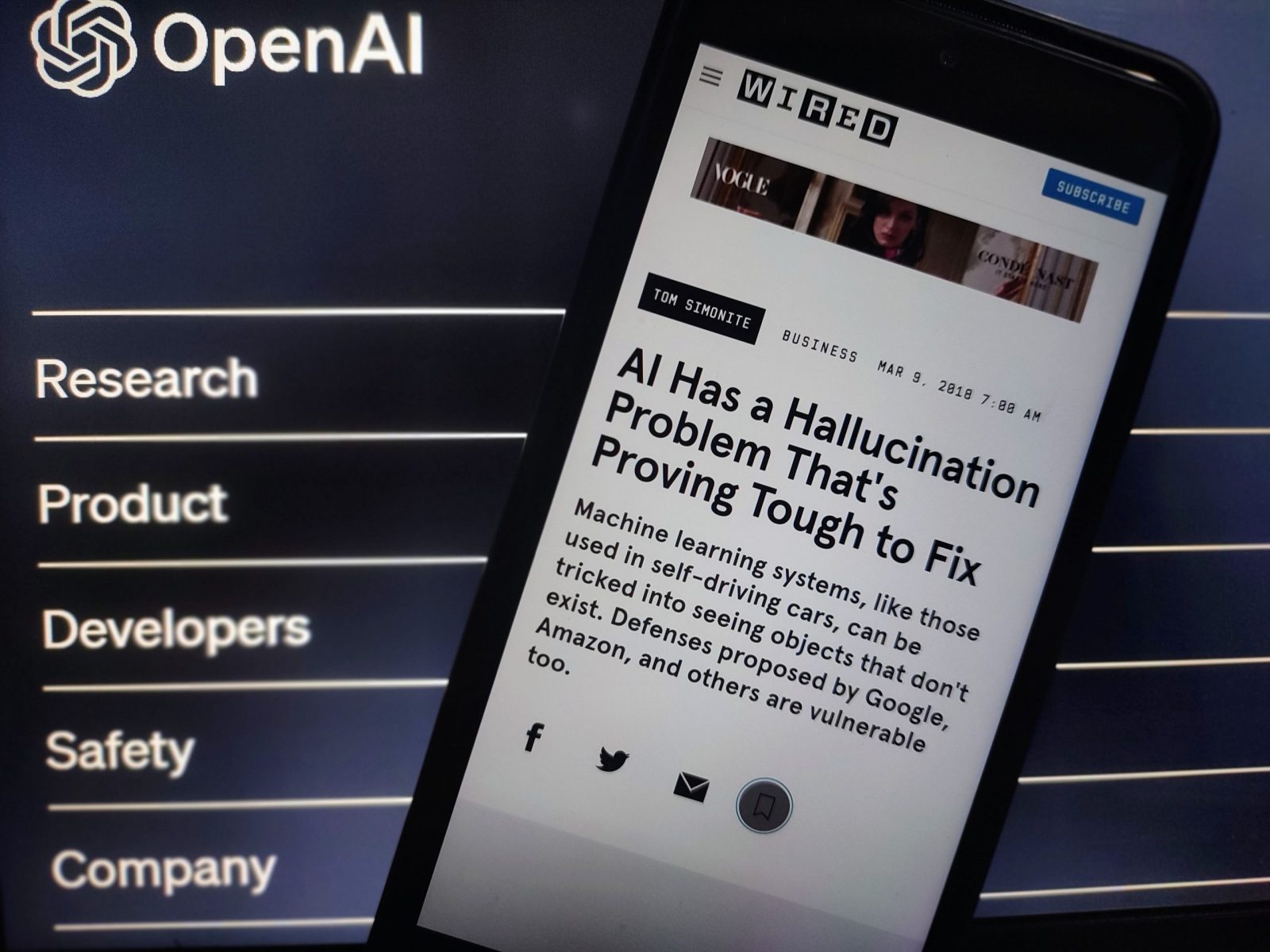

過去半年,以 ChatGPT 為首的大型語言模型(LLM)吸引全球目光。縱然這類自然語言生成 AI 系統相當全能,但絕不是萬無一失,不少用家發現 AI 不時「說謊」和虛構事實,這種現象稱作「AI 幻覺」(Artificial Hallucination)。究竟這種 AI 失誤與人類大腦運作可有相通之處?研究人員又如何減低 AI 產生「幻覺」的機會?

在人工智能研究領域,「幻覺」是指 AI 虛構事實的問題,例如 Google 大型語言模型 Bard 初試啼聲,就誤把「首張太陽系外行星的照片」歸功於韋伯太空望遠鏡。早前有紐約律師利用 ChatGPT 向法庭呈交法律動議,結果引述不存在的「虛假」案例,令該名律師可能要面臨法律制裁,這同樣是「AI 幻覺」的典型例子。

澳洲聯邦科學與工業研究組織(CSIRO)轄下 Data61 分部研究科學家 Sarah Vivienne Bentley 與戰略前瞻高級研究顧問 Claire Naughtin 在學術交流平台 The Conversation 指出,人類同樣素來有編造假資訊的問題,當然有人是故意為之,但有部分卻是「無意」的失誤,背後可能出於認知偏差,又或心理學稱為「捷思法」(Heuristics)的思維。

所謂「捷思法」,是指人類面對擺在眼前的問題,大腦會自動聯繫到過去經驗,在有限的認知情況下,嘗試以成見快速推敲正確答案。這亦可以是人為偏見的典型例子,可導向錯誤判斷。另一個相關的理論叫「暈輪效應」(Halo Effect),意味著我們對事物建立的初步印象,將影響我們隨後的互動行為。

「AI 幻覺」恐持續干擾現實

相對而言,大型語言模型 AI 之所以捏造事實,背後原因不像人類運用「捷思法」,節省腦力思考來迅速理解世界,以致出現錯誤判斷。「AI 幻覺」是指 AI 未能對應輸入數據預測出最適當的結果。大型語言模型的運作原理,是從大量文本數據中進行深度學習,以預測不同詞彙最有可能出現的序列。

大型語言模型之所以產生「AI 幻覺」,很可能是用於訓練的數據有缺陷,或者系統還未接受足夠相關訓練。至於系統如何透過編程深度學習相關數據,同樣是潛在的影響因素。當人類嘲笑 AI 經常出錯或者犯低級錯誤時,往往忘記了這些缺陷與人類關係密不可分。

目前人類正多管齊下嘗試消解「AI 幻覺」,如進行負責任的數據管理,確保訓練數據多樣和有代表性;研究偏見認知如何滲入 AI 系統,是對症下藥的關鍵步驟,涉及「可解釋人工智能」(Explainable AI)的研究領域,即對 AI 決策進行追本溯源的調查;把公眾利益放在首位,使 AI 系統更熟習人類價值觀,同樣重要。

早前 ChatGPT 開發商 OpenAI 發表新研究論文,提出避免「AI 幻覺」的辦法,例如改良 AI 模型的訓練模式,每當推理步驟正確,AI 就會給予正面的自我反饋,而不僅僅在最後結論給予正面反饋,這種取向稱為「過程監督」(Process Supervision)。

然而,目前尚未知論文能否通過同行評審,有專家亦對其建議的成效存疑,但即使「AI 幻覺」尚未能完全消除,相信都不足以阻嚇人類使用 AI,意味著「幻覺」對現實的干擾,可能陸續有來。