日前陶傑先生提及 AI 無人汽車發展,筆者認為論述相當有趣,並希望於本文略略討論相關道德議題。

學術界的普遍共識是人工智能發展會取代社會中一部分的職業,當中最常引用的例子就是司機。無人駕駛技術在近年相繼取得技術上突破,在路試情況下,車輛自動操作已非天方夜譚。但這是否代表在未來不再需要人類司機?這一點筆者並不認同,因為 AI 不能(亦不應該)代替人類作出道德判斷,這是科技應有的界限。

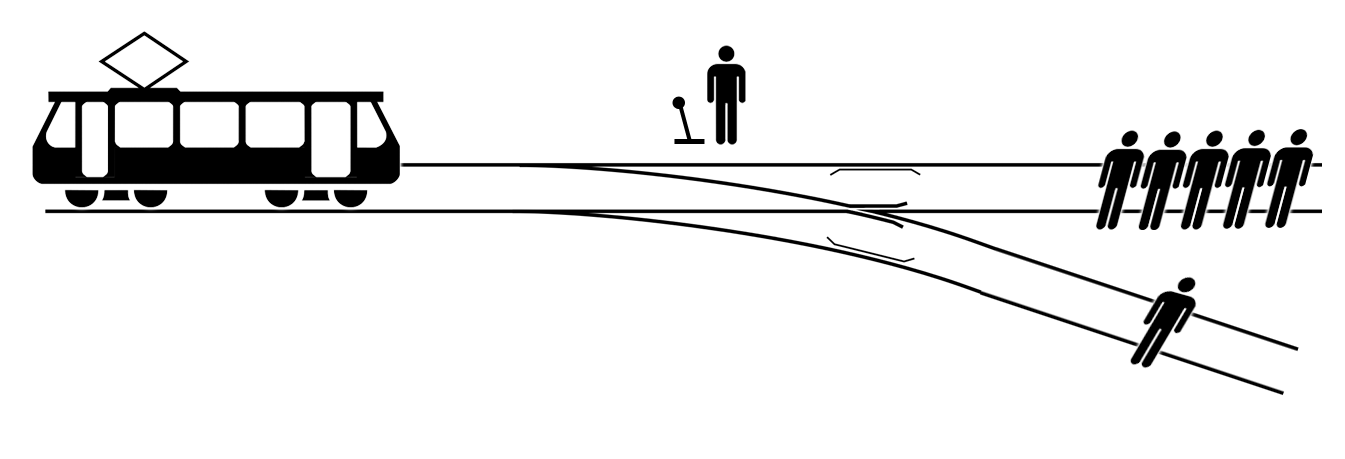

對哲學有興趣的讀者,可能已經聽過這個著名的道德兩難議題 —— 電車實驗(The Trolley problem):假設一架電車失控將會撞死前方 5 個路人;但你可以拉動一個手掣令電車轉向,改而撞死 1 個路人。無論拉還是不拉,當中都涉及複雜的道德倫理思考和批判。

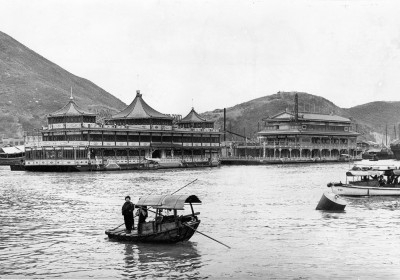

以色列殿堂級學者哈拉瑞(Yuval Noah Harari)在著作「21 世紀的 21 堂課(21 Lessons for the 21st Century)」中,提出了人工智能版的電車實驗:假設一架無人駕駛汽車失控,快將撞向前方 5 個亂過馬路的路人,但電腦程式可以將車轉向,改為撞死在行人路上等候燈號的 1 個路人,汽車生產商有權/應該將汽車永遠預設撞向人少的方向嗎?人工智能應該用甚麼準則去決定誰人該死?

在另一個假設情況,無人駕駛汽車將失控墜崖,車內的乘客必然喪命,此時電腦程式可以將汽車轉向,改為撞向前方私家車,人工智能又該如何決定犧牲哪一個人?假設人工智能汽車已經連接大數據,得知前方私家車乘客為 70 歲曾經做過心藏手術的老翁,車禍後死亡機率為 99%;而失控汽車乘客為任職警察的年青男性,體格強健兼佔中清場有功,但他墜崖後身亡機率為 97% 略低於老翁,人工智能汽車是否應該直衝落懸崖?假設失控汽車受陶傑先生文中的 50 歲東尼監督,東尼又可否/應否在兩條人命中做決定?

本文提到的問題,讀者心中可能會有不同答案。但唯一肯定的是,道德思考不應該假手人工智能作最後決定。雖然理論上 AI 沒有人類的主觀(Subjectivity)影響,但近年多個學術研究清楚指出,電腦程式在編寫的時候已經因為程式員的主觀性或數據可用性(Availability)的偏差而存在偏見。例如 Google 曾經將同性戀者及性罪行犯關聯;又例如因為視像數據不普及,所以人面析別技術(Facial recognition)對於黑人準確度較白人低。醫生、律師等其他職業當中所牽涉的道德問就更加複雜,我預期人工智能可以在各行各業減少人力資源及提高生產力,但大多數行業都不會被 AI 輕易取替。