美國人口參考局估計,地球至今累計約 1,200 億智人出生。除非發生全球災難,否則 5,000 年後人類依然會存在;按哺乳類的平均壽命計算,50 萬年後應仍在繁衍。這意味著,未來將可能有 80 萬億人口誕生。道德哲學家 William MacAskill 在新書 What We Owe the Future: A Million-Year View 中,主張以有效利他主義(Effective altruism)進行推理:「這不僅讓我思考當代問題,還開始探究人類更長遠的將來。」

35 歲的 MacAskill 是位長期主義(longtermism)者,提倡以人類長遠利益出發來考慮當前決策。他是牛津大學林肯學院的副教授,也是「有效利他主義中心」( Centre for Effective Altruism)的聯合創辦人兼主席,提供數據分析助慈善事業有效運用捐贈;並合辦 Giving What We Can,組織成員承諾捐出至少 10% 收入予慈善機構(MacAskill 本人更捐出大部分收入)。

MacAskill 認為,人類後代數目龐大,其需求應被視為當前決策的重要考慮。以氣候變化為例,懷疑論者經常以其不確定性為由而拒絕行動,但此論點存在謬誤。以政府間氣候變化專門委員會(IPCC)的評估及建議為例,至本世紀末,在中至低程度的碳排放下,氣溫將上升攝氏 2.5 度。「這並不確定。上升 2 度或更低的機率是 10 分之 1,但也有 10 分之 1 機會超過 3.5 度。與最理想的預測結果相比,低於 2 度或令人鬆一口氣,但超過 3.5 度,情況會惡劣得多。不確定性理應讓人們有更多理由擔心,而非更少。」

又例如,有些科學家預測強人工智能(AGI)將於未來 50 年內普及,有些甚至估計只需 20 年,但對 AGI 可能導致反烏托邦的研究卻嚴重不足。「假如當年納粹德國勝出二戰,其政權屹立數百年並主導了 AGI 發展,那麼人們將可能永遠落入納粹意識形態的操控。」此例子並非要指出人類能有多壞,而是面對不確定,應趁為時未晚,及早預防最壞情況:例如放緩 AI 在某些領域方面的研究、權衡 AI 各種發展模式與應用範圍的利弊,惟現今正正缺乏如何制衡全球 AI 發展的相關研究。

然而,MacAskill 並不支持反對經濟增長、消費,甚至減少生育以營造更好未來的論調。因現階段科技尚未足以排除所有災難風險。他假設人類在 100 年前停止發展,將帶來 2 種可能:回到艱苦的農耕生活,或繼續使用化石燃料導致氣候災難。唯有透過技術發展和經濟增長,才能避免氣候危機、生物恐怖主義和更多潛在威脅。「另外,假設你說服了 192 個國家停止經濟增長,但有一個國家繼續,複合增長意味著不久之後,一個國家就是整個世界的經濟。長遠來看,你真的甚麼也沒做。」

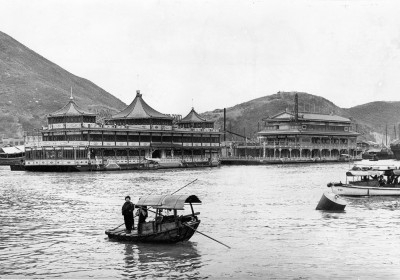

本書以探討人類價值觀為核心;回顧歷史,這顯然並非一成不變。就如廢除奴隸制度,現今被視為理所當然,但蓄奴卻一度被當作正常不過的事。MacAskill 強調道德進步是可能發生的,但需要有人提出道德理由來推動。儘管他強烈抨擊奴隸制度、殖民主義和極端父權社會,但他強調,西方也可從其他文化中汲取教訓。例如非洲許多土著哲學也提倡關心後代,箇中自有其文化原因:在狩獵採集社會,技術變革非常緩慢,因此從 1,000 年前祖先身上學會的,1,000 年後傳授給後代或仍然可行。

但在快速變化的社會,人們對遙遠的未來倍感脫節。MacAskill 強調的是,當面對廣闊的時間差距,與巨大的不確定,應能趁現在埋下改變的種子;而保持謙遜,更不表示要自滿於現狀或停擺。標準經濟預測為未來 100 年每年增長約 2%,MacAskill 指,那麼人們應考慮當發生一場毀滅 50% 人口的災難,或人口增長顯著增加 —— 面對兩種極端可能時,及早思考對策。